В 2025 году вопросы приватности становятся ключевыми не только для отдельных пользователей, но и для бизнеса, особенно когда в чатах обсуждаются чувствительные данные: код, идеи, персональные сведения. Поэтому важно понимать, как именно в ChatGPT устроена политика хранения, удаления и экспорта чатов, и как её изменения могут повлиять на безопасность ваших данных.

В этой статье мы разберём текущие правила, ограничения, юридические нюансы и дадим рекомендации, как минимизировать риски. При этом используем термины: ChatGPT, chat gpt, чат gpt, чат гпт — в соответствии с принятым распределением.

Как ChatGPT сейчас хранит чаты и файлы

Основные механизмы хранения и удаления

По официальным данным, чаты и файлы, загруженные в чат, остаются привязанными к аккаунту, пока пользователь не удалит их вручную. При удалении чат исчезает из интерфейса мгновенно и становится «назначенным на удаление» в системе — в течение примерно 30 дней он будет удалён полностью, за исключением случаев, когда требуется сохранить данные по юридическим или безопасности причинам.

Удаление чата нельзя отменить — он не восстанавливается ни через интерфейс, ни через API.

Файлы, прикреплённые к чатам, следуют тому же жизненному циклу: если вы удаляете чат, файл, если он всё ещё активен, также будет запланирован к удалению вместе с чатом.

Временные чаты (Temporary Chats)

Если вы используете режим «временный чат», то они автоматически удаляются спустя 30 дней — без необходимости ручного вмешательства. При этом такие чаты не сохраняются в истории и не включаются в обучение моделей (если другие настройки позволяют).

Когда полное удаление может не произойти

Есть исключения:

- Если чат уже был «деидентифицирован» (то есть оторван от аккаунта пользователя)

- Если OpenAI обязан сохранять данные дольше из соображений безопасности или закона

- В некоторых случаях резервные копии системы могут удерживать данные дополнительно до 30 дней (прибыв до недоступности через внешние интерфейсы)

Контроль использования ваших чатов для обучения моделей

Отключение обучения

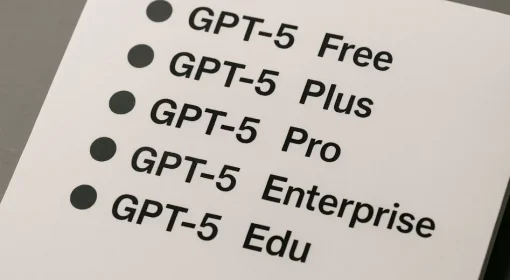

Пользователи Free, Plus и Pro могут отключить использование их разговоров для обучения моделей. Это делается через Settings → Data Controls → отключить “Improve the model”.

После этого разговоры всё ещё остаются видимыми в истории, но не участвуют в тренировке моделей.

Исключения и бизнес-версии

В версиях ChatGPT Business, Enterprise и API-интеграциях по умолчанию данные пользователей не используются для обучения моделей (если не включено иное). То есть такие клиенты получают повышенный уровень приватности.

Новый юридический нюанс: хранение удалённых чатов по постановлению суда

Изменение, которое стало ключевым в 2025 году: OpenAI обязана по судебному решению сохранять удалённые чаты бессрочно в своих логах, даже если пользователь пытается удалять их полностью. Это коснулось всех пользователей: Free, Plus, Pro, Team. Такие данные не публичны и доступны только ограниченному числу сотрудников для юридических процессов или аудита. Версии с контрактом Zero Data Retention, Enterprise или Edu могут быть исключены из этого правила.

Это значит: удаление чата в вашем интерфейсе уже не гарантирует, что он исчезнет из внутренних систем — его можно скрыть, но не исключить полностью из учёта.

Экспорт данных и права пользователей

Экспорт истории

Пользователи ChatGPT (Free, Plus, Pro) имеют возможность экспортировать свои данные. Это делается через Settings → Data Controls → Export Data. После подтверждения вы получите на почту архив (.zip) с историей чатов и связанной информацией.

Срок жизни ссылки на экспорт обычно ограничен — ссылка может истечь через 24 часа.

Ограничения для рабочих пространств Team

У многих пользователей Team-плана отсутствует автоматическая возможность экспорта рабочих чатов. На практике для некоторых рабочих пространств экспорт данных реализован вручную через копирование текста — и это вызывает жалобы с точки зрения прав пользователей на переносимость данных.

Права на удаление и корректировку

OpenAI предоставляет пользователям права на удаление или корректировку своих персональных данных через портал приватности или форму запроса. Однако эти права могут не распространяться на данные, которые уже «деидентифицированы» или удерживаются по юридическим обязательствам.

Юридический и нормативный контекст

Регуляции и штрафы

На европейском уровне и в странах с жёстким регулированием данных (например, GDPR) OpenAI уже столкнулась с претензиями. В частности, в Италии компания была оштрафована за нарушение правил обработки пользовательских данных, несовершенное информирование и прозрачность.

Также со стороны органов контроля возрастает внимание к тому, как ИИ-платформы обрабатывают персональные данные, хранение удалённых чатов и обязательный экспорт/удаление.

Конфликты с законом и требования суда

Судебные постановления могут привести к тому, что компании обязаны сохранить данные, которые пользователи хотели удалить. Это ограничивает степень, в которой сервисы могут удовлетворить просьбы пользователей об удалении данных.

Риски и слабые места с точки зрения приватности

- Удаление в интерфейсе не гарантирует полного удаления из систем

- Хранение удалённых чатов под судебным решением ставит под вопрос уверенность пользователей

- Некоторые GPT и внешние действия могут собирать больше данных, чем заявлено

- Уязвимости в кастомных GPT: возможно «утекание инструкций» или незаконный доступ к пользовательским данным

- Ограниченность экспорта данных в рабочих пространствах (Team) может противоречить регламентам защиты данных

Рекомендации по защите приватности при использовании ChatGPT

Для пользователей, которые хотят минимизировать риски, можно порекомендовать следующие практики:

- Отключите использование чатов для обучения моделей, если эта опция доступна

- Регулярно удаляйте ненужные чаты и используйте режим временных чатов для чувствительных тем

- Экспортируйте данные заранее, если планируете закрыть аккаунт или сменить сервис

- Не вводите в чаты конфиденциальную информацию (пароли, персональные данные) без необходимости

- По возможности выбирайте версии ChatGPT с «Zero Data Retention» или бизнес-версии с контрактом, гарантирующим отсутствие использования данных

- В проектах, где важна высокая приватность, рассматривайте гибридные схемы: хранение критичных данных локально, обработка запросов через модель минимально раскрывая контекст

Заключение

Правила приватности в Chat GPT претерпевают серьёзные трансформации в 2025 году: пользовательский контроль над историей, право на экспорт, но и судебные обязательства сохранять удалённые чаты.

Хотя вы можете удалить чат из интерфейса и запретить его использование в тренировке, внутренние системы могут удерживать данные под юридическими предписаниями. Поэтому важно не полагаться исключительно на интерфейс, а понимать технические и юридические ограничения, выбирать планы с расширенной приватностью и принимать активные меры защиты данных при общении с чат gpt.